Le traitement du langage naturel est un des sujets phares de la recherche en intelligence artificielle depuis le milieu des années 50. Les évolutions et révolutions dans l’analyse sémantique assistée par les algorithmes sont saisissantes. Du fameux test de Turing érigé en étalon de la capacité des machines à dialoguer “comme des humains”, aux fantasmes cinématographiques de films comme “Her” où le personnage principal tombe amoureux de son assistante personnelle, faire parler les robots est un thème central du développement de l’IA.

Avec les avancées récentes du côté du machine learning et du deep learning, et l’augmentation des capacités de calcul, de nouvelles approches ont fait leur apparition ces derniers mois et révolutionnent le champ de recherche pour la compréhension de texte, mais aussi pour la génération de réponses. On vous en dit plus dans le numéro de cette veille !

L’analyse sémantique, indispensable pour un bon chatbot

Peu importe la technique utilisée, l’analyse sémantique est un point clé dans la construction d’une expérience de conversation automatisée de qualité. Nous avons conçu une méthode efficace pour traiter des gros volumes de données afin d’accompagner la compréhension des attentes des utilisateurs de la cible du chatbot. Ce premier niveau d’analyse s’effectue sur des historiques de conversations passées, des historiques de chat ou des transcriptions téléphoniques par exemple, pour comprendre au mieux les besoins exprimés par les utilisateurs et leur façon de formuler ces intentions.

Cela permet de classifier les données de conversations par grand thèmes puis d’en extraire les intentions pour orienter la conception du scénario de conversation et entraîner les modèles de reconnaissance de langage naturel. Une étape indispensable dans le processus de conception et d’entraînement de votre chatbot dont nous vous parlions plus en détails dans cet article : L’IA pour améliorer l’IA : classifier pour mieux annoter.

BERT, le “transformer” qui vient disrupter l’algorithme de Google

Le monde du référencement naturel se réinvente constamment, au gré des évolutions de l’algorithme de Google, de ses changements technologiques, et de ses politiques de qualité. Après les bien connus Pingouins et autres Panda ou Rank Brain, la nouvelle mise à jour majeure du coeur de l’algorithme de classement des résultats de recherche porte le nom d’une brique technologique d’analyse sémantique : BERT.

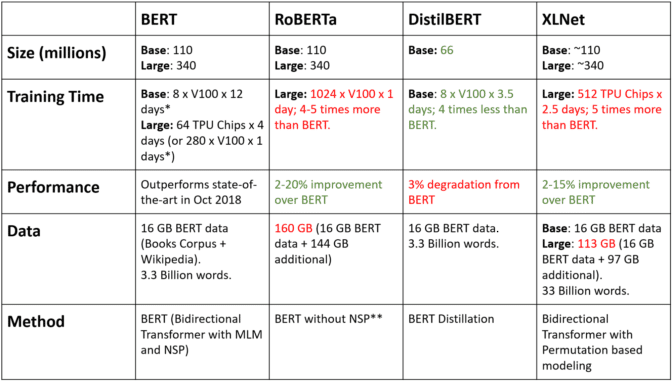

De son nom complet “Bidirectional Encoder Representations from Transformers”, BERT est le premier d’une longue famille de “transformers”, des modèles que l’on “pré-entraînés” pour la compréhension du langage naturel. Un travail de fond qu’il nous faut ensuite affiner avec les spécificités de chaque thématiques étudiées.

Concrètement, Google veut aller plus loin dans la compréhension des requêtes complexes, vers l’avènement d’un “web sémantique” attendu depuis de nombreuses années. Un déploiement logique pour avancer de concert avec la prise en compte du vocal et des phrases parlées, bien plus compliquées à faire comprendre à la machine qu’une suite de quelques mots clés.

Projet ouvert à l’ensemble de la communauté pour que chacun apporte sa pierre à l’édifice (et pour se challenger pour savoir qui aura le meilleur modèle), BERT a connu de nombreuses déclinaisons depuis quelques mois. Facebook a par exemple présenté sa version RoBERTa, entraîné à partir de 10 fois plus de données que le BERT original et avec une puissance de calcul supérieure. A l’inverse, la startup Hugging Face a proposé sa version “distillée”, moins gourmande en ressources et donc plus facile d’accès.

De l’analyse à la génération de texte 100% automatisée

Après l’analyse du langage naturel et sa compréhension, la machine doit délivrer une réponse. En piochant dans un catalogue de connaissances préétabli, dans le cas de chatbots de support client, ou en générant une réponse de façon 100% automatique. Nous arrivons là aussi rapidement dans le domaine du fantasme pour le moment. Un aspect “magique” de l’intelligence artificielle renforcé par les annonces récentes d’OpenAI qui aurait créé un générateur de texte trop bon et trop dangereux pour être mis à disposition du grand public. Il s’agit du fameux “GPT-2” capable, selon ses créateurs, d’écrire des articles aussi bons que ceux des journalistes du New-York Times.

La Tribune a très bien résumé le projet et ses limites dans un article paru fin septembre à retrouver ici. Pour vous rendre compte de ce que ça donne réellement, le mieux est encore d’aller tester. Rendez-vous ici. Il ne vous reste plus qu’à donner une phrase ou un début de phrase à la machine pour qu’elle construise la suite de votre récit. Pour autant l’exploitation d’un tel modèle dans le contexte d’un chatbot de relation client parait encore trop risqué (et coûteux) par rapport une approche avec des réponses pré-définies.

Les outils d’analyses sémantiques sont indispensables pour comprendre les besoins et intentions des utilisateurs afin de créer des chatbots efficaces !

Mais aujourd’hui on peut aller beaucoup plus loin avec des outils comme BERT qui vont venir augmenter beaucoup de projets liés au traitement automatique du langage dans les mois à venir, quand cela est vraiment nécessaire bien sûr. Analyse, compréhension, génération de texte, la technologie avance pour vous proposer des chatbots de plus en plus performants !